Crawler (hay còn gọi là web crawling hoặc indexing) là quá trình các bot (robot) của Google tự động duyệt qua từng trang web, thu thập thông tin và tạo ra một bản sao lưu của toàn bộ nội dung trên Internet. Bản sao lưu này được gọi là index (chỉ mục). Mỗi khi bạn thực hiện một tìm kiếm trên Google, công cụ tìm kiếm sẽ nhanh chóng quét qua chỉ mục này để tìm ra những trang web phù hợp nhất với từ khóa của bạn. Và bài viết, SEOTCT sẽ cung cấp chi tiết để giúp bạn đọc có cái nhìn sâu sắc hơn về crawl và cách hoạt động của nó trong SEO.

Crawler là gì?

“Crawl” là một thuật ngữ trong lĩnh vực công nghệ thông tin, đặc biệt là trong lĩnh vực tìm kiếm web (web crawling). Quá trình “crawl” (hay “web crawling”) đề cập đến việc tự động thu thập thông tin từ các trang web trên Internet.

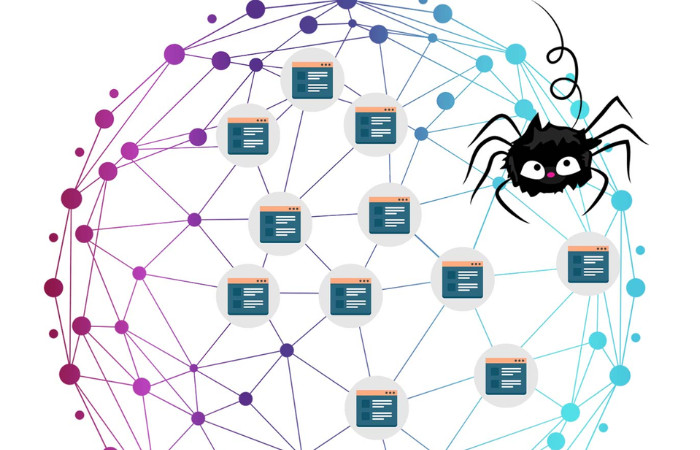

Trong ngữ cảnh của các công cụ tìm kiếm như Google, Bing, và Yahoo, việc “crawl” rất quan trọng để xây dựng cơ sở dữ liệu của họ. Các chương trình máy tính gọi là “web crawlers” hoặc “web spiders” được thiết kế để tự động duyệt qua các trang web trên Internet, theo các liên kết, thu thập thông tin từ các trang này và đưa về cho việc lập chỉ mục (indexing).

Vì sao crawl web lại quan trọng trong việc tìm kiếm thông tin trên mạng?

Crawl dữ liệu đóng vai trò vô cùng quan trọng trong việc tìm kiếm thông tin trên mạng, điều này được thể hiện rõ qua các điểm sau:

- Thu thập và lập chỉ mục hàng triệu trang web: Công cụ tìm kiếm có thể sử dụng quá trình crawl để thu thập thông tin từ hàng triệu trang web. Khi người dùng tìm kiếm, việc này giúp cung cấp kết quả chính xác và phù hợp ngay lập tức.

- Đảm bảo thông tin mới nhất và chính xác: Với sự gia tăng không ngừng của nội dung trên web, các công cụ crawl dữ liệu liên tục quét qua các trang web để cập nhật thông tin mới. Điều này giúp người dùng truy cập thông tin mới nhất và đáng tin cậy.

- Hỗ trợ phân tích dữ liệu và đánh giá chiến dịch: Bằng cách thu thập và phân tích thông tin từ nhiều nguồn, doanh nghiệp có thể đưa ra quyết định thông minh và thực hiện chiến lược tiếp thị hiệu quả hơn, dựa trên dữ liệu được crawl.

Việc crawl dữ liệu không chỉ giúp cải thiện kết quả tìm kiếm mà còn mang lại nhiều lợi ích khác, như giúp người dùng tiết kiệm thời gian, công sức và đạt được kết quả tìm kiếm chính xác và phù hợp nhất cho nhu cầu của họ.

Nguyên tắc hoạt động của bot công cụ tìm kiếm crawl

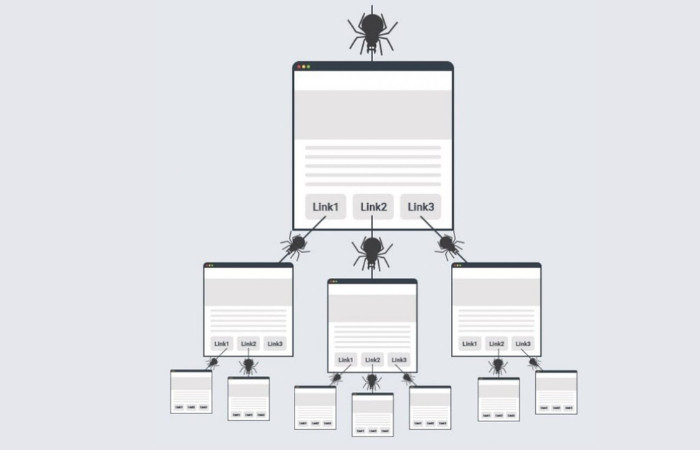

Bot công cụ tìm kiếm bắt đầu bằng việc duyệt qua một danh sách các URL được cung cấp cho nó. Từ những URL này, bot sẽ thu thập dữ liệu từ các trang web và tìm kiếm các liên kết đến các URL mới để mở rộng danh sách thu thập.

Quá trình crawl dữ liệu diễn ra liên tục và kéo dài qua các URL có liên quan. Bot sẽ ưu tiên các trang web dựa trên các yếu tố như lượng backlink, lưu lượng truy cập và tầm quan trọng của nội dung. Các trang web có các yếu tố này cao thường được coi là cung cấp thông tin chất lượng và có thẩm quyền, do đó sẽ được ưu tiên crawl dữ liệu trước.

Ngoài ra, bot công cụ tìm kiếm tuân theo các chính sách về tần suất và thứ tự thu thập dữ liệu. Điều này giúp đảm bảo rằng các trang quan trọng và có cập nhật mới sẽ được crawl dữ liệu thường xuyên hơn. Kết quả là, khả năng cung cấp kết quả tìm kiếm chính xác và kịp thời cho người dùng được cải thiện.

Chặn Google Crawling những dữ liệu không quan trọng trên Website bằng cách nào?

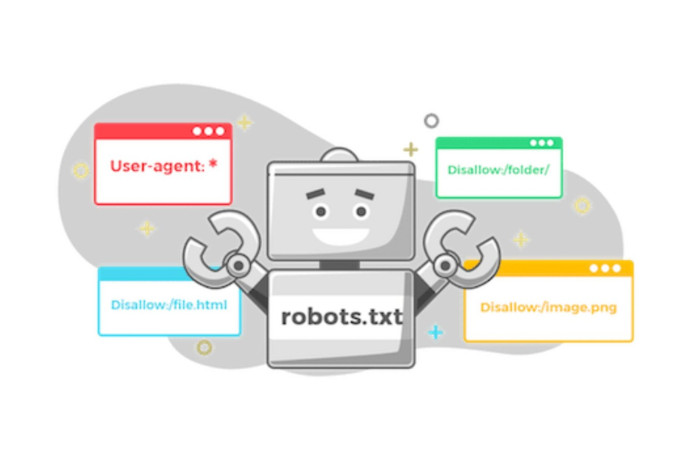

Sử dụng Robots.txt để kiểm soát crawling

Tệp Robots.txt được đặt tại thư mục gốc của trang web và chứa các chỉ thị cho bot công cụ tìm kiếm về việc thu thập dữ liệu. Điều này giúp bảo vệ thông tin nhạy cảm và tối ưu hóa hiệu suất crawl data. Bạn có thể kiểm soát tốc độ thu thập dữ liệu để giảm tải cho server và cải thiện hiệu suất trang web. Khi Googlebot phát hiện tệp Robots.txt, nó sẽ tuân thủ các chỉ thị, đảm bảo các trang quan trọng được lập chỉ mục và xếp hạng tốt trên kết quả tìm kiếm.

Tối ưu hóa Crawl Budget

Crawl Budget là số lượng URL mà Googlebot có thể thu thập trước khi dừng lại. Để tối ưu hóa quá trình này, hãy đảm bảo Googlebot không quét các trang không quan trọng hoặc trùng lặp. Sử dụng file Robots.txt để chỉ định Googlebot không nên truy cập vào các phần không cần thiết của trang web. Cân nhắc sử dụng các chỉ thị như thẻ “Canonical” hoặc “Noindex” để hướng dẫn Googlebot xử lý trang một cách chính xác, tránh vấn đề về duplicate content.

Tính năng tham số URL trong Google Search Console

Tham số URL là các đoạn mã thêm vào URL để phân biệt các phiên bản khác nhau của cùng một nội dung trang web. Tính năng này trong Google Search Console cho phép bạn chỉ định cho Googlebot biết cách xử lý các tham số này, lập chỉ mục hoặc bỏ qua. Điều này giúp ngăn chặn Googlebot crawl dữ liệu trang trùng lặp, duy trì chỉ mục của bạn sạch sẽ và hiệu quả.

Yếu tố ảnh hưởng đến Web Crawler trong quá trình crawling là gì?

Crawl dữ liệu không phải là một quá trình ngẫu nhiên mà được điều chỉnh bởi nhiều yếu tố quan trọng. Dưới đây là những yếu tố mà bạn cần chú ý để “hợp tác” với Googlebot một cách hiệu quả hơn:

Domain

Tên miền chứa từ khóa chính hoặc liên quan đến nội dung trang web sẽ được đánh giá cao hơn, giúp tăng cơ hội xuất hiện trong kết quả tìm kiếm.

Backlinks

Các liên kết đến trang web từ các nguồn chất lượng và đáng tin cậy sẽ giúp tăng sự thân thiện với các công cụ tìm kiếm và cải thiện thứ hạng trang web.

Internal Links

Liên kết nội bộ không chỉ giúp bot dễ dàng duyệt qua các trang mà còn cải thiện trải nghiệm người dùng, giữ họ ở lại trang web lâu hơn và tăng hiệu quả SEO.

XML Sitemap

Sử dụng sitemap giúp thông báo cho các công cụ tìm kiếm về bài viết mới và thay đổi trên trang web, giúp cập nhật nhanh chóng.

Duplicate Content

Nội dung trùng lặp có thể giảm giá trị SEO và bị phạt bởi Google. Sử dụng các lệnh chuyển hướng 301 hoặc lỗi 404 để giải quyết vấn đề này và cải thiện hiệu quả crawl và xếp hạng.

URL Canonical

Đảm bảo không có nhiều URL dẫn đến cùng một nội dung. Canonical URL giúp Google hiểu phiên bản nào của URL là chính thức và xếp hạng trong kết quả tìm kiếm.

Giúp Google và người dùng hiểu rõ hơn về nội dung trang web và tăng khả năng thu hút người dùng đến từ khóa mục tiêu.

Bot Crawl của các công cụ tìm kiếm phổ biến hiện nay

Googlebot của Google

Trong SEO việc hiểu rõ về cách các công cụ tìm kiếm phổ biến thực hiện việc crawl dữ liệu là vô cùng quan trọng. Một trong những bot quan trọng nhất mà chúng ta không thể không nhắc đến chính là Googlebot của Google.

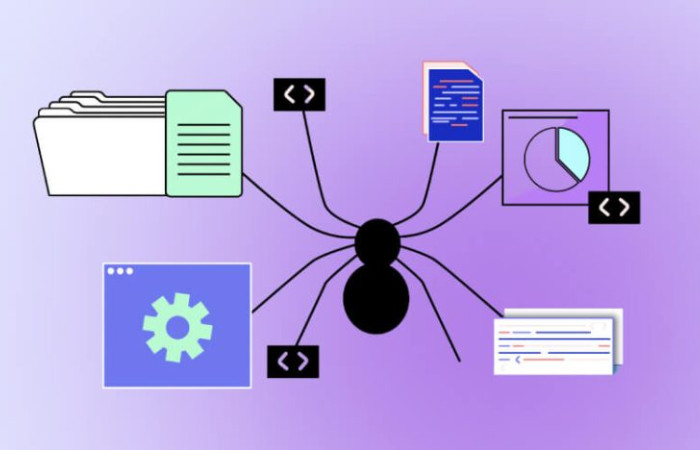

Googlebot không chỉ là một phần mềm robot thông thường. Được phát triển bởi Google, Googlebot đóng vai trò quan trọng trong việc thu thập thông tin trên các trang web. Điều này giúp đảm bảo rằng nội dung trên trang web được cập nhật đầy đủ và xuất hiện đúng cách trên kết quả tìm kiếm của Google.

Việc sử dụng thông tin mà Googlebot thu thập, bao gồm tiêu đề, nội dung, liên kết và các yếu tố khác, có thể giúp bạn kiểm tra và tối ưu hóa trang web của mình. Điều này sẽ giúp cải thiện vị trí của trang web trên trang kết quả tìm kiếm của Google một cách đáng kể.

Ngoài việc giúp cải thiện vị trí trên kết quả tìm kiếm, Googlebot cũng hỗ trợ theo dõi các thay đổi trên trang web. Thông qua việc này, bạn có thể thực hiện các điều chỉnh cần thiết để duy trì và nâng cao thứ hạng của trang web của mình.

Bingbot của Bing

Bingbot, một phần không thể thiếu trong hệ thống tìm kiếm của Bing, đóng vai trò quan trọng trong việc thu thập và cập nhật dữ liệu từ các trang web trên Internet. Nhiệm vụ hàng đầu của Bingbot là đảm bảo rằng kết quả tìm kiếm mà Bing cung cấp là chính xác và đáng tin cậy đối với người dùng.

Một số hoạt động chính của Bingbot

- Thu thập dữ liệu: Bingbot tự động thu thập thông tin từ các trang web bằng cách theo dõi các liên kết trên các trang này. Thông tin như tiêu đề, nội dung, liên kết và các yếu tố khác được lấy và lưu trữ vào cơ sở dữ liệu của Bing.

- Cập nhập dữ liệu: Bingbot thường xuyên quét lại các trang đã thu thập để đảm bảo rằng thông tin được cập nhật và chính xác. Ngoài ra, nó theo dõi các thay đổi trên trang web để cập nhật cơ sở dữ liệu của Bing theo thời gian.

- Xếp hạng trang web: Bingbot đánh giá các yếu tố như nội dung, độ tin cậy và tối ưu hóa SEO để xác định thứ hạng của trang web trên kết quả tìm kiếm của Bing. Quá trình này không chỉ giúp cải thiện hiệu suất mà còn đảm bảo sự hiển thị chất lượng của trang web trên nền tảng tìm kiếm Bing.

Yandexbot của Yandex

Yandexbot là một phần quan trọng trong hệ thống tìm kiếm của Yandex. Công việc chính của Yandexbot trong quá trình crawl là thực hiện các nhiệm vụ sau:

- Crawl dữ liệu: Yandexbot thực hiện việc crawl dữ liệu bằng cách theo dõi các liên kết trên các trang web để thu thập thông tin quan trọng như tiêu đề, nội dung, liên kết và các yếu tố khác của trang web.

- Lưu trữ và cập nhật dữ liệu: Yandexbot lưu trữ và cập nhật định kỳ dữ liệu trong cơ sở dữ liệu của Yandex, đảm bảo rằng thông tin luôn được cập nhật và chính xác.

- Quét lại và điều chỉnh: Yandexbot quét lại các trang web đã thu thập để đảm bảo rằng thông tin được cập nhật và chính xác. Nó cũng theo dõi các thay đổi trên trang web để điều chỉnh cơ sở dữ liệu.

- Đánh giá và xác định thứ hạng: Cuối cùng, Yandexbot đánh giá và xác định thứ hạng của các trang web trên kết quả tìm kiếm của Yandex dựa trên các tiêu chí như nội dung, độ tin cậy và sự tối ưu hóa SEO.

Trên đây là toàn bộ thông tin về crawl là gì cũng như nguyên tắc hoạt động mà SEOTCT đã giới thiệu đến bạn đọc. Chúng tôi hy vọng là qua bài viết này sẽ giúp bạn đọc hiểu rõ hơn về craw.

TRẦN CÔNG TÍN

CEO/Founder tại SEOTCT

Với hơn 5 năm kinh nghiệm trong lĩnh vực SEO, Google Ads và Digital Marketing. Trước đó, tôi đã thành công trong việc tối ưu hóa SEO cho nhiều dự án, giúp cải thiện đáng kể thứ hạng từ khóa lên TOP google, mang lại lượng truy cập và chuyển đổi cho doanh nghiệp. Hy vọng rằng với kiến thức mà tôi chia sẻ sẽ mang lại nhiều giá trị hữu ích và góp phần thúc đẩy sự thành công cho doanh nghiệp của bạn.